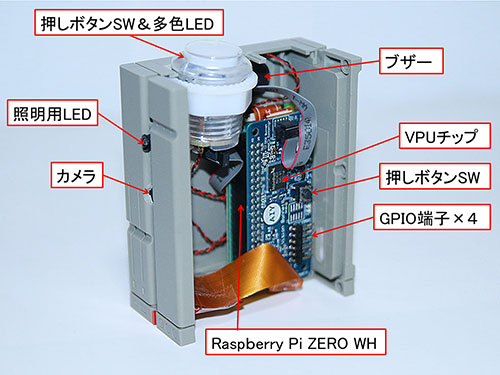

AIYボンネットに載っているVPUチップ、「MA2450」は、Movidius社(インテルが買収)のMyriad 2ファミリーのビジョンプロセッシングユニットで、4 Gbit DDRとTeraFLOPSを誇る浮動小数点演算機能、画像処理機能を持ち、高速でディープニューラルネットワークに基づく分類等の処理を行ってくれますので、クラウドに頼らずローカルで画像から物体認識するのに役だっていてくれます。VPUは最近、USBスティック版も販売されるようになりましたが、結構高価で(秋月電子通商で1万円程度)、カメラ、ラズパイ付きのVISION KIT(12.4k円)はかなりお得感がありました。あと、ボンネット基板には、空きGPIOの端子が4本引き出されているのと、ラズパイとスマホとでBluetoothのペアリングをする際に使用する押しボタンスイッチが載っていました。 組み立て説明書はなく(以前に購入したVOICE KITには冊子の説明書が添付されていた)、以下のサイトの案内書きがあり、これを参考にして組み立てました。 https://aiyprojects.withgoogle.com/vision/  起動 起動

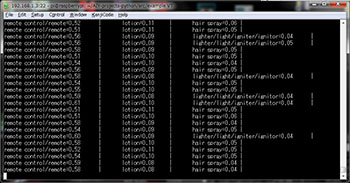

家庭で使う時はIPアドレスはだいたい推測できるので、スマホを使わないでなんとか接続しています。下図は、PCからログイン後のAIYプロジェクトディレクトリに入ったところです(「喜び検出」のソフトの自動起動は解除しました)。  多くのPythonによるサンプルプログラムが入っています。以下、コマンドを入力して試したものをいくつか紹介します。

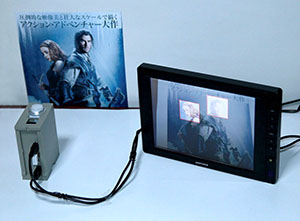

製作したVISIONユニットにはミニX68000の筐体の正面、両タワーの隙間部分にカメラを取り付けています。趣味で撮影したモデルの写真を見せたところ、人物だと認識すると、筐体トップのLEDが青く点灯し、さらに、笑顔であればブザーを鳴らし黄色で点灯します。笑顔に近い表情では青~黄色の微妙な色で光りました。

映画のちらしを見せたところ、カメラ画像の中の人物の顔部分を複数検出してハイライト表示しました。2つ目の画像の横向きの女性の顔は写真では認識していますが、実際はちらちらと認識したり、しなかったりしました。横顔はなかなか難しいようです。

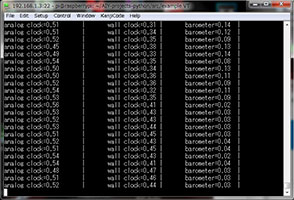

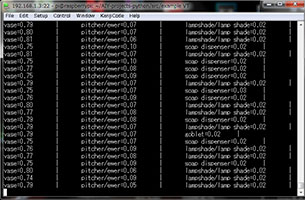

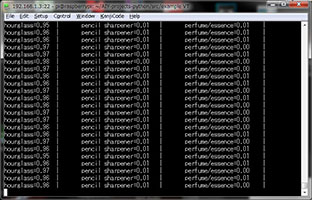

カメラのライブ画像をリアルタイムに認識し事前に学習された物体の中から確率が高いものを3つ、リアルタイムにSSH端末画面に出力します。部屋にある小物をいろいろと見せて反応を確認しました。

あらかじめ教え込まれたデータの質と量にもよると思いますが、ほぼ的確な検出をしてくれました。砂時計は計時中だと認識率が上がりました。最後は難題かと思いながらセッティングしましたが、まさかCDの円盤でなく歌手の衣服に着目するとは意外でした(白いから実験用白衣・・・)し、そのリアルタイムの検出繰り返しの中で「ニプル」なんてのもあり、「おいおいどこを見てんだ!」とつっこみを入れたくなりました。あと、ここにはありませんが、お城の置物を置いて「障害物」と検出され時には、可笑しくてつい笑ってしまいました。 ・空きGPIOに押しボタンスイッチを取り付け、短押しでリセット、長押しでシャットダウンするようにする。 ・空きGPIOにロータリーDIPスイッチを付け、自動起動ソフトを選べるようにする。 ・空きGPIO出力からケーブルを出し、X68000等の起動制御ができるようにする(顔認識で起動など)。 どれもすぐにできそうなネタですが、X68000本体の改造に時間をとられ、4ヶ月過ぎてしまいました・・・。

|

メニューへもどる